Heute schreibe ich seit langer Zeit mal wieder hier im Blog. Auch wenn das Theme seit dem letzten Update noch nicht mal ansatzweise fertig ist… egal … was mir heute über den Weg gelaufen ist, muss ich hier einfach mit Euch teilen. Also los geht es mit der Geschichte: “Wieso Du auf Updates und Backups nicht verzichten solltest” Eine Saga über gehackte WordPress, SEO Spam und richtig mieses Router Phishing.

Dass böse Hacker ungeschützte Webseiten und veraltete Content-Management-Systeme gerne für diverse Zwecke missbrauchen, sollte mittlerweile jedem bekannt sein. Den Payload, der mir heute über den Weg gelaufen ist, war so perfide SEO-relevant, dass ich ihn hier mit Euch teilen möchte.

Inhaltsverzeichnis

Was ist passiert?

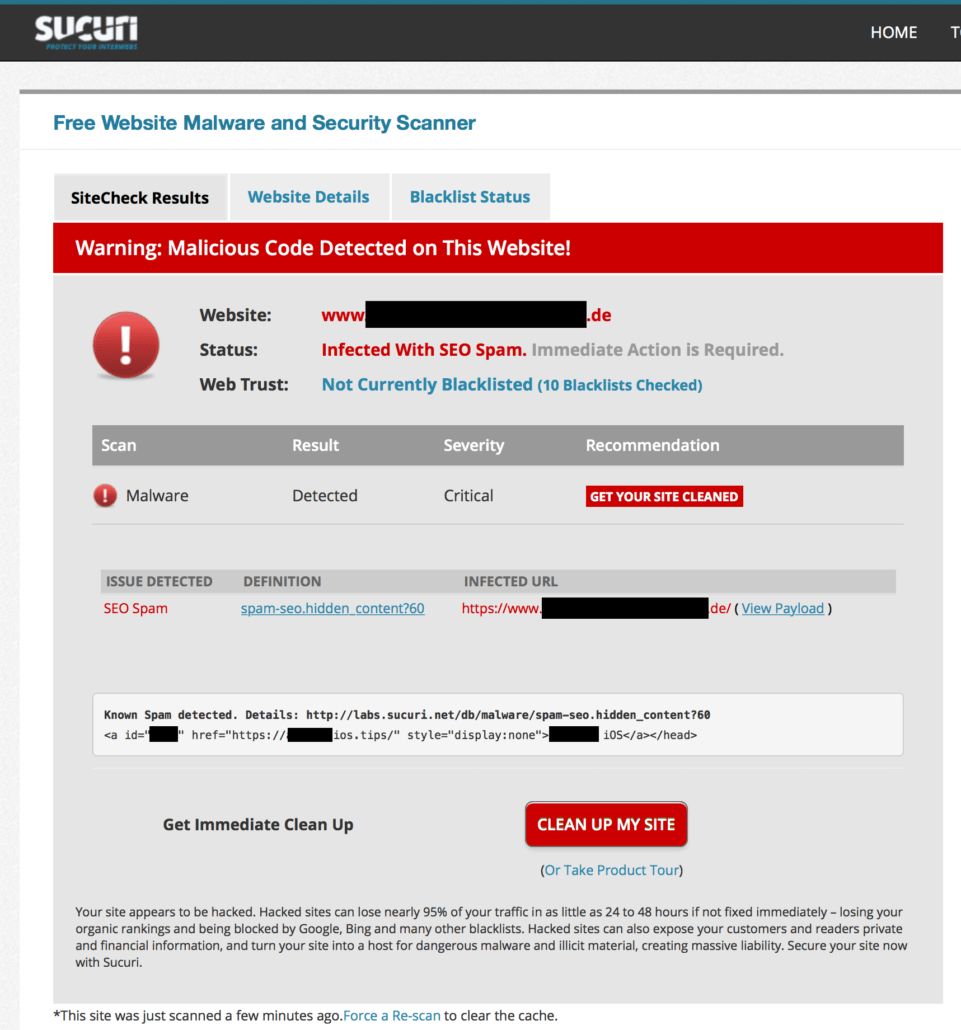

Von einem Bekannten wurde mir gemeldet, dass man neuerdings auch auf Security-Blacklisten wegen Black Hat SEO, bzw. SEO Spam landen könne. Da ich es nicht so recht glauben wollte, schließlich wurde SEO Spam bislang “nur” zum Bescheißen von Google und Monetarisieren der Rankings eingesetzt und mir erschloss sich nicht, wieso man dadurch zu einem sicherheitsrelevanten Problem wird. Die ausgenutzten Schwachstellen sind häufig ja bekannt und die Seiten einfach nicht gepatched…

Doch, siehe da, es gibt tatsächlich bei SUCURI einen Malware-Eintrag für spam-seo.hidden_content?!

In der Beschreibung steht was von versteckten Spam-Links und Black Hat SEO, aber immer noch nichts, was aus meiner Sicht einen Eintrag als Malware rechtfertigt.

Mein Interesse war aber geweckt und so schaute ich mir den Payload der Seite mal etwas genauer an. Das erste auf das ich stoß war der folgende Code-Schnipsel:

Also ein mittels display:none versteckter Link im <head> der Seite – so gut – so normal (bei Crap Hats). Wie man im Artikel bei sucuri nachlesen kann, gibt es natürlich noch wesentlich ausgefeiltere Methoden den Link zu verstecken.

Übrigens zieht der Link im <head>, denn wie wir auf der SMX 2018 in München erst kürzlich von John Müller erfahren durften, beendet ein HTML-Element wie <a> den Kopfbereich der Seite! Also sorgt jedes <img>, <p>, etc. das eigentlich in den <body> der Seite gehört, im <head> dazu, dass dieser für den GoogleBot an dieser Stelle endet und alle nachfolgenden Anweisungen intepretiert werden, als befänden diese sich im <body>.

Kleiner Ausflug: Das führt zum Beispiel auch dazu, dass ein Canonical-Link oder HREFLANG-Tag im Head ignoriert wird, wenn ein eingebundenes Script im <head> davor versehentlich ein Element ausgibt, beispielsweise ein Tracking-Pixel als IMG!

Aber zurück zum Thema Black Hat SEO! Also weiter im Code geschaut … und … siehe da:

Das ist mal richtig mies. Also ich meine jetzt nicht diesen pseudo Text und den weiteren Spamlinks, der einfach “nur” irgendeine Drecksseite zum ranken bringen soll, sondern den Link direkt darunter, kurz vor Ende des </body>:

<p hidden><a id="████" href="https://192-168-o-1.███/">192.168.0.1 login</a></p></body>

Da fiel es mir wie Schuppen von den Augen! Wisst ihr, wieso die Seite durch diese Payload nun sicherheitsrelevant wurde? Damian weiß es bestimmt, aber könnt ihr es euch erklären?

Auflösung in den Kommentaren 😉

Wollt ihr schnelles und sicheres Hosting? Checkt meinen WP-Hoster Vergleich aus!

White Hat versus Black Hat SEO versus Cracker SEO

Eventuell haben Sie schonmal von der Unterscheidung in ‘White Hat SEO’ und ‘Black Hat SEO’ gehört. Im Allgemeinen werden unethische Optimierungstaktiken, welche gegen Googles Richtlinien und damit gegen deren Nutzungsbedingungen verstoßen als ‘Black Hat’ Techniken bezeichnet. Im Gegensatz dazu stehen die sogenannten ‘White Hat’ Techniken bei denen man sich an die Vorgaben und Richtlinen der Suchmaschinen hält.

Beispielsweise werden im ‘Black Hat SEO’ der Suchmaschine mittles IP-Delivery (Cloaking) andere Inhalte angezeigt, als für den Besucher sichtbar. Auch die automatisierte Erstellung (Spamming) von Inhalten und Backlinks mittels Blogkommentaren, Foreneinträgen und der Erstellung von Profilen auf Social Media Plattformen werden in der Regel zu den ‘Black Hat’ Methoden gezählt.

Diese Methoden können zum Ausschluß der Seite aus den Suchmaschinen führen und sollten für jede nachhaltige Suchmaschinenoptimierung strikt tabu sein.

Wichtig anzumerken ist allerdings, dass diese Methoden entgegen mancher Darstellungen NICHT illegal sind. Also keine Strafrechtlichen Konsequenzen nach sich ziehen. Sicherlich könnten die eine oder andere ‘Black Hat Taktik’ zivilrechtliche oder wettbewerbsrechtliche Folgen haben, aber dies ist nichts für den Staatsanwalt.

Ganz anders sieht es bei richtigen Crackern aus:

Die gezielte Manipulation der Suchmaschinen hat eine vollkommen neue Dimension erreicht, seit Hacker mit großer technischer Expertise, ausreichend krimineller Energie und Kreativität SEO als lukrative Einnahmequelle entdeckt haben!

Diese scannen gezielt nach angreifbaren Webseiten, welche meist mit weit verbreiteten Open Source Content Management Systemen betrieben werden.

Angreifbar sind hauptsächlich nicht upgedatete Systeme mit bereits öffentlich bekannten Sicherheitslücken und passenden Exploits (Methoden zur Ausnutzung der Sicherheitslücke). Seltener werden auch 0-day Exploits ausgenutzt, also Sicherheitslücken welche dem Hersteller/Entwickler noch gar nicht bekannt sind. Hat sich ein Hacker dadurch erst einmal Zugang zum System verschafft, kann dieser ohne Einschränkungen zahlreiche SEO-Relevante Manipulationen vornehmen.

Dies wird gemeinhin als Hacking bzw. Cracking bezeichnet.

Übliche Manipulationen und deren Folgen für das Ranking in den Suchmaschinen

- Domains mit viel Traffic werden oft auch als Plattformen für die Verbreitung von Malware wie Viren und Trojaner missbraucht, wodurch der Hacker an weitere sensible Daten der Benutzer gelangen kann (Kreditkartendaten, Backdaten, Passwörter).

Ebenso werden die infizierten Rechner als Zombies in einem großen Netzwerk gehalten und dienen bei Bedarf als Quellen für weitere Angriffe wie z.b. DDoS-Attacken.

Da Google verständlicherweise keine User auf Malware-Seiten führen möchte, führt dies unweigerlich zu einem Ausschluß ihrer Domain aus den Suchmaschinen! - Kleinere Domains, welche über wenig Traffic verfügen, werden meist für die Generierung von Backlinks missbraucht. Diese werden oft nur für die Suchmaschine sichtbar, mittels Parsing des User-Agents oder mittels IP-Delivery (Cloaking) vor den normalen Besuchern versteckt. Solche Manipulationen kann man erkennen, in dem man sich den Inhalt über die Abfrage ‘wie Google-Bot’ über die Google Webmaster Tools anzeigen lässt.

- Domains mit viel Trust und starken Backlinks (häufig .edu Domains oder Seiten bekannter Organisationen) werden oft so manipuliert, dass diese für sehr lukrative Begriffe wie selbst auf der ersten Seite ranken. Besucher, welche dann über diese Suchanfragen auf die Seite gelangen, werden entweder direkt auf einen Shop umgeleitet oder bekommen Kaufmöglichkeiten in einem vollflächigem iframe über der eigentlichen Seite zu sehen. Diese Manipulation ist sehr schwer zu entdecken, da diese Inhalte nur sichtbar werden, wenn Google als Referer die richtigen Keywords enthält! Ein regelmäßiges Monitoring der eingehenden Backlinks und deren Linktexte ist hier ebenso sinnvoll, wie die Überprüfung von Keywords des organischen Traffics. Im Zweifel schafft jedoch nur ein manueller Code-Review Gewissheit.

- Konkurrierende Domains und Wettbewerber werden mit gezielten Angriffen wie z.b. Synflood oder anderen DoS bzw. DDoS-Attacken angegriffen. Diese sind dadurch (zeitweise) nicht mehr erreichbar und verlieren nicht nur Ihre Kunden, sondern auch Ihre Rankings, denn Google schickt ungerne Benutzer aus einem Suchergebnis auf eine nicht funktionierende Seite!

Ebenfalls können unliebsame Wettbewerber unter Umständen mit massenhaft generierten – schädlichen Backlinks beschossen werden. Dies lässt sich nur sehr schwer unterbinden und man muss eine Menge Daten ins Disavow Tool zeitnah einpflegen, damit nicht einer von Googles Antispam Filter anspringt.

So können Sie Ihre Seite schützen

Leider kann es niemals 100%ige Sicherheit gegen Angriffe auf Software geben, aber da Crap Hats in der Regel auf leichte Beute im großen Stil aus sind, kann man die größten Einfallstore und Winke mit dem Zaunpfahl abstellen und die eigene Seite ein wenig sicherer machen.

Vermeiden Sie Hinweise auf Schwachstellen

Für den Hacker wichtig zu wissen ist: Um welches System handelt es sich, also welche Software wird dort verwendet und in welcher Version liegt diese vor. Diese Hinweise sollten Sie nach Möglichkeit vermeiden. Erkennbar sind beispielsweise weit verbreitete Content Management Systeme, wie Joomla! oder auch WordPress durch Meta-Tags, wie

<meta name="generator" content="Joomla! 1.5 - Open Source Content Management" />

oder das Vorhandensein typischer Verzeichnisse, wie /wp-admin /typo3 /fileadmin oder Dateien, wie readme.txt, wp-config.php, etc.

Die wichtigsten Punkte für sicherere Webseiten

- Investieren Sie in IT-Sicherheit! Dies schützt Ihre Investition in SEO!

- Führen Sie regelmäßig Backups durch!

- Alle verfügbaren Updates regelmäßig und zeitnah nach Erscheinen einspielen!

- In Ordner- und Dateistruktur von der Standard-Installation abweichen!

- Die Admin-Ordner und das Backend per htaccess schützen!

- Keine Hinweise auf die Art und Version des CMS liefern!

- Nach Möglichkeit: Regelmäßige Datei- und Code-Reviews um versteckte Manipulationen zu entdecken!

- Hinweise, Keywords und Abrufe ‘wie Google-Bot’ in den Webmaster Tools überprüfen

- Eingehende Backlinks und deren Linktexte überwachen

- Server nach aktuellem Stand absichern!

Falls Sie Opfer einer Manipulation geworden sind, hilft es oft nur, die Änderungen rückgängig zu machen, die Sicherheitslücken zu schließen und einen Antrag auf Wiederaufnahme bei der Suchmaschine Ihres Vertrauens zu stellen.